A mesterséges intelligencia végleg átveszi az irányítást a guglizás fölött

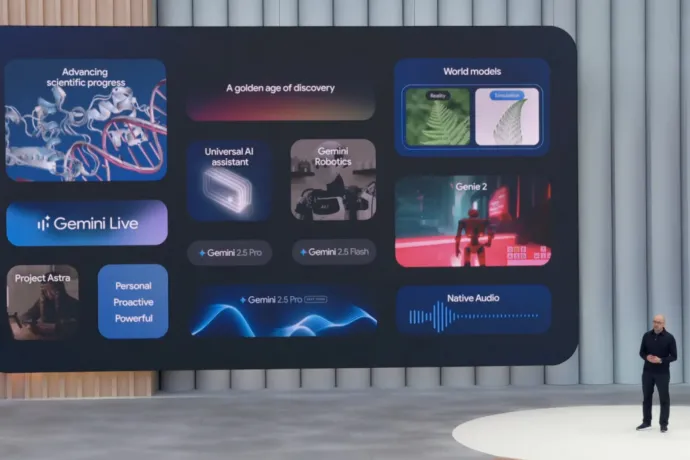

Nem kellett prófétának lenni, hogy valaki előre megmondja, a Google megint végig a mesterséges intelligenciáról fog beszélni az I/O nevű fejlesztői konferenciáján, de a rend kedvéért szögezzük le: a Google megint végig a mesterséges intelligenciáról beszélt. A visszaszámlálást, és a nyitóvideót is MI-vel generálták, sőt, az első MI tíz perccel a kezdés előtt elhangzott, az improvizatív prüntyögéssel hangoló Toro Y Moi mondta, hogy a zeneipar úgyis efelé megy, akkor is, ha ő nem vesz részt benne. Szóval igen, minden az MI-ről szól a Google-nél, a lényeg röviden:

- a tavaly bemutatott Project Starline mostantól Google Beam néven fut, és nemcsak a Google szerint teheti élethűbbé az online meetingeket az MI segítségével, hanem például a cuccot kipróbáló Verge szerint is;

- a tavalyi I/O slágertémája, a mindenbe integrált Geminivel személyre szabott virtuális asszisztenst ígérő Project Astra már bőven több egy techdemónál, és a bemutató alapján nagyon gördülékenyen működik;

- az OpenAI MI-ügynökeire hasonlító, decemberben bemutatott, böngészőket használó Project Mariner pedig továbbfejlődik, és egy kicsit a Geminibe is beköltözik.

Mindezt Sundar Pichai, a Google vezérigazgatója foglalta össze nagyon zanzásítva a bemutató elején, de előtte még arról beszélt, hogy a Google nemcsak vezeti, hanem formálja is ezt a piacot, a legfrissebb modelljeik pedig a mérvadó benchmarkok alapján jobbak az összes versenytársuknál. Azt sem felejtette el megemlíteni, hogy a legújabb modelljük, a Gemini 2.5 Pro nemrég végigjátszotta a Pokémon Blue-t, bár azt már igen, hogy ezt amúgy az Anthropic kezdte. És amúgy is, sokkal jobb volt, amikor a Twitch chat játszotta végig a Pokémon Blue-t. AA-j, sosem feledünk.

A pokémonos vicceskedés után Pichai elmondta, hogy a Gemini alkalmazásnak már több mint 400 millió aktív felhasználója van, később pedig mondott egy még durvább számot is, az MI-összefoglalókat állítólag 1,5 milliárd ember szokta látni. Tudják, ezek azok az idegesítő összefoglalók a Google keresések fölött, amiket tavaly korlátoztak, miután olyasmiket tanácsolt, hogy ragasztót kell tenni a pizzaszószba, gázolajat a spagettibe, és meg kell enni naponta legalább egy követ. Pichai szerint ez az elmúlt évtized legsikeresebb újítása a keresésben, többen is keresnek miatta,

szóval logikus, hogy hamarosan teljesen átveszi a hatalmat az MI a guglizás fölött, leginkább azzal, hogy érkezik egy külön MI-mód a keresőbe.

A Google szerint az emberek egyre hosszabb, egyre komplexebb kérdéseket tesznek fel a keresőben – ami nem is meglepő, hiszen egy tavalyi tanulmány szerint a keresőoptimalizálás teljesen tönkretette a keresést, szóval vagy úgy keres mindenki, hogy beírja mindent után, hogy reddit, vagy úgy tesz, mintha a ChatGPT-t használná. Vagy konkrétan azt is használja, mert ez is egyre gyakoribb. Erre reagál most a Google az MI-móddal, amiben a legjobb modellek lesznek benne, és az ígéretek szerint nagyjából azt fogja tudni, amit tavaly is végigdemóztak.

Azaz, felteszünk neki egy kérdést, és helyettünk végigcsinálja az összes keresést, és aztán egy, az eredményekre szabott kezelőfelületen megmutatja az eredményt, amiről aztán faggathatjuk tovább is. Ehhez a módhoz hozzá lehet majd kapcsolni más Google-ös cuccokat is, első körben a Gmailt, ezáltal még személyre szabottabb találatokat fog adni – ha például megkérdezzük, hogy mit lehet csinálni Nashville-ben, a hírleveleinkből tudni fogja, hogy a múzeumok tuti érdekelnek bennünket, a repülőjegy alapján pedig azt is megmondja, hogy konkrétan akkor mi van ott, amikor mi ott leszünk.

Egy másik példában az amerikai profi baseball-ligában feltűnt új, torpedó alakú ütőkről kérdezték az MI-módot, ami össze is foglalta, hogy a nevesebb játékosok mennyit javultak emiatt tavalyhoz képest, bár azt bemondásra kellett elhinni, hogy az adatok tuti pontosak is lesznek. Itt jött be az OpenAI-t, meg a saját tavalyi demójukat idéző ügynökösködés is az MI-módba. Ha meccsre akarunk menni, a kereső kitúrja a legolcsóbb jegyeket a kért paramétereknek megfelelően – az OpenAI ügynökét is ezzel demózták januárban, akik próbálták, nem voltak elájulva tőle.

Ja, és arra is képes lesz az ügynökké váló Gemini, hogy a többi Google alkalmazás, meg a korábbi emailjeink alapján a mi stílusunkban válaszoljon a leveleinkre, szóval a mítingeken való odafigyelés után az emailekre válaszolgatást is lehúzhatjuk a munkahelyi listáról.

A kereséshez kapcsolódik az is, hogy a Google csinált egy külön modellt arra, hogy az emberek virtuálisan felpróbálhassák a ruhákat, amiket online kinéztek – ehhez előbb leképezi az illető testét egy feltöltött kép alapján, aztán kielemzi a szóban forgó ruha anyagát, aztán ezek alapján összeilleszti a kettőt. Ilyesmivel mások is próbálkoznak, inkább kevesebb, mint több sikerrel, és főleg kiterjesztett valóságban, a kamerával, ez a megoldás azoknál pár fokkal megbízhatóbbnak tűnt elsőre.

A kamerát viszont a Google is szereti használni, például a Google Lensszel, hamarosan pedig valós időben is kereshetünk majd a kameránk segítségével. Nagyjából mintha videóhívással felhívnánk a Google keresőt, aztán a kameraképen vagy képernyőmegosztással rámutogatnánk dolgokra, hogy ez mi, az mi. A demók alapján a legostobább kérdésekre is készségesen válaszol, ha valakinek a gyerek éppen abban a korszakban van, hogy mindenre azt kérdezi, hogy „de miért?” annak megvan az új legjobb barátja. És akkor ott van még a tavaly belengetett Project Astra, ami mindent csinál egyszerre, ez jelenleg így néz ki:

A keresésen kívül volt még szó arról, hogy a Google hiperszuper gyors és hatékony új modelljeivel mennyire jól lehet vibe kódolni (állításuk szerint nagyon, aztán ki tudja), hogy a fehérjék szerkezetét megjósoló AlphaFoldból nőhet ki az első AGI (általános mesterséges intelligencia, ami már eléri, vagy túl is szárnyalja az emberek kognitív képességeit), és ez a valaha volt leghasznosabb tudományos technológia lehet és a zenét (Lyria 2), mozgóképet (Veo 3) és képeket (Imagen 4) generáló modellekről is beszéltek. A filmgeneráláshoz egy új, Flow nevű eszköz is érkezik, ehhez Darren Aronofskyval álltak össze, és nagyon szeretnék elhitetni, hogy jó ötlet, ha animátorok helyett az MI-vel csináltatjuk meg a számítógépes grafikákat.

A végén pedig jött a hónapok óta terítéken lévő Android XR, amivel a cég a Google Glass után megint megpróbálkozik az okosszemüvegekkel, csak első ránézésére sokkal jobb lesz az eredmény. Itt két szemüvegről van szó, az egyik a Samsunggal közösen gyártott Project Moohan, ami lényegében a koreaiak válasza az Apple Vision Próra, a másik pedig egy Project Aura néven futó okosszemüveg, olyasmi, amit a Meta villantott tavaly az Orionnal. Csak a Google szemüvege nem olyan vastag, szóval szívesebben venné fel az ember az utcára is.

A demó alapján a szemüveg elég menő dolgokat tud. Igaz, a Google Meetbe érkező, ott tökéletesen is működő, valós idejű fordítás a színpadon nem annyira ment vele, de ijesztően sok mindent lehetett vele csinálni anélkül, hogy elő kellett volna venni egy telefont, és az androidos ökoszisztéma, meg a Google látszólagos hajlandósága miatt talán alkalmazások is lesznek rá egyszer. Persze csak ha megjelenik, és halandó emberek is meg tudják venni, ami az Orion gyártási költségeiből kiindulva egyelőre egyáltalán nem biztos, a Google szemüvegéről pedig egyelőre még annál is kevesebbet tudunk.

A teljes közvetítést alább lehet visszanézni, Sundar Pichai bevezetője pedig itt olvasható teljes egészében.